Wie kann Predictive Analytics die Liquiditätsplanung verbessern?

Predictive Analytics nutzt historische Cashflows und externe Daten, um Muster zu erkennen und zukünftige Liquidität vorherzusagen. Machine Learning automatisiert Aktualisierungen, erhöht die Genauigkeit und ermöglicht Szenarioanalysen – so können Treasury-Teams Risiken früher erkennen, Hedging optimieren und bessere strategische Entscheidungen unterstützen.

Mit Nomentia können Sie Ihre Liquiditätsplanung zu einem hohen Grad automatisieren und die Vorhersagen samt den dahinter liegenden Annahmen vereinheitlichen. So erhalten Sie erstaunlich präzise Plandaten und sparen wertvolle Zeit in der Planung.

Ein Computer kann enorm große Datenmengen verarbeiten und hoch komplexe Analysen durchführen, die Sie allein mit Excel nicht umsetzen könnten, das liegt auf der Hand. Rechenkapazität und Statistik allein reichen aber nicht aus, um belastbare Plandaten zu erzeugen.

Wir haben jetzt ein vielschichtiges Verfahren entwickelt, das die Präzision von Predictive Analytics erheblich steigert und damit einsatzbereit für den Treasury-Alltag macht. Mit diesem Verfahren ermittelt Nomentia für jede Ihrer Planungskategorien individuell die beste Berechnungsmethode und erreicht damit erstaunlich gute Ergebnisse. In Kombination mit dem Fachwissen Ihrer Treasury-Abteilung können Sie Ihre Planung so zu einem hohen Grad automatisieren und die Qualität Ihrer Planwerte erhöhen.

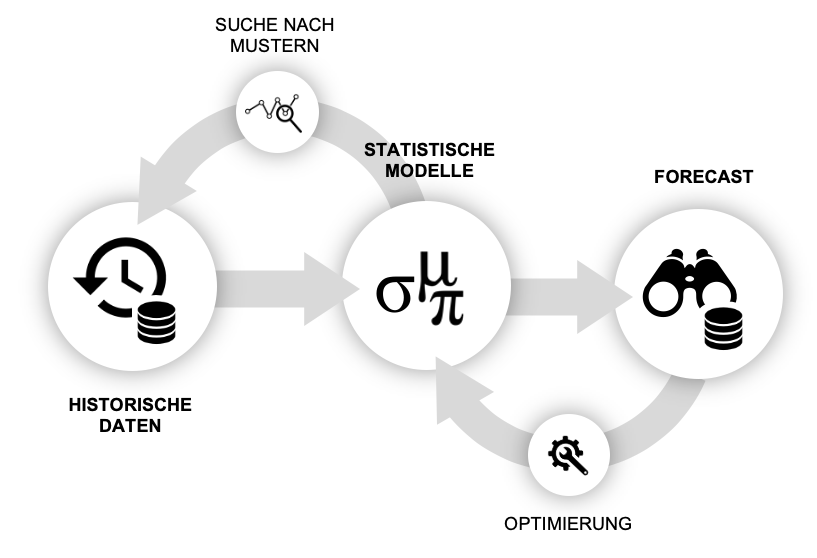

Im Laufe dieses Prozesses definieren und berechnen Sie mit Nomentia Informationen zu sämtlichen Einflussfaktoren auf Ihre Cashflow-Entwicklung (Abb. 2) und digitalisieren so Ihre Liquiditätsplanung. Auf diese Art können Sie Ihre Planung nicht nur konzernweit flexibel an unterschiedliche Bedürfnisse anpassen, sondern auch personenunabhängig gestalten. Das ist wertvoll, wenn MitarbeiterInnen das Unternehmen verlassen oder in Urlaub oder Karenz gehen.

In dieser Digitalisierung des Prozesses steckt der größte Vorteil von Predictive Analytics: Denn sie ermöglicht es, eine Vielzahl an Einflussfaktoren gleichzeitig in Ihrer Planung zu berücksichtigen. Das ist manuell nahezu unmöglich, statistische Modelle und Machine-Learning-Methoden können aber genau das leisten und ermöglichen so in der Regel auch genauere Vorhersagen. Was das genau bedeutet, lesen Sie in diesem Artikel.

Was ist Predictive Analyitics?

Viele Treasurer analysieren mithilfe von Excel die Cashflows der vergangenen Jahre, um in ihnen Verläufe und Muster zu finden, auf deren Basis sie Entwicklungen vorhersagen können. Predictive Analytics funktioniert nach dem gleichen Prinzip, allerdings auf einem technisch wesentlich ausgereifteren Niveau und mit einem deutlich höheren Automatisierungsgrad.

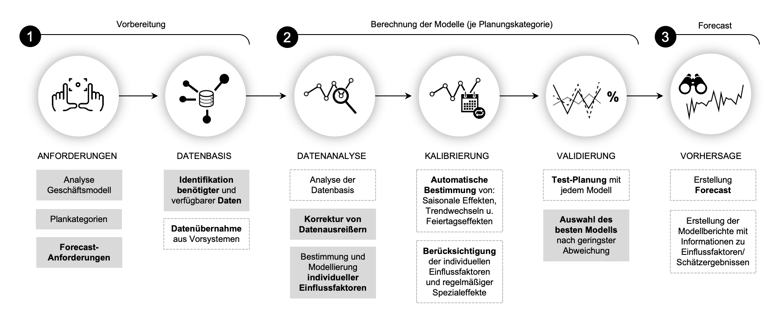

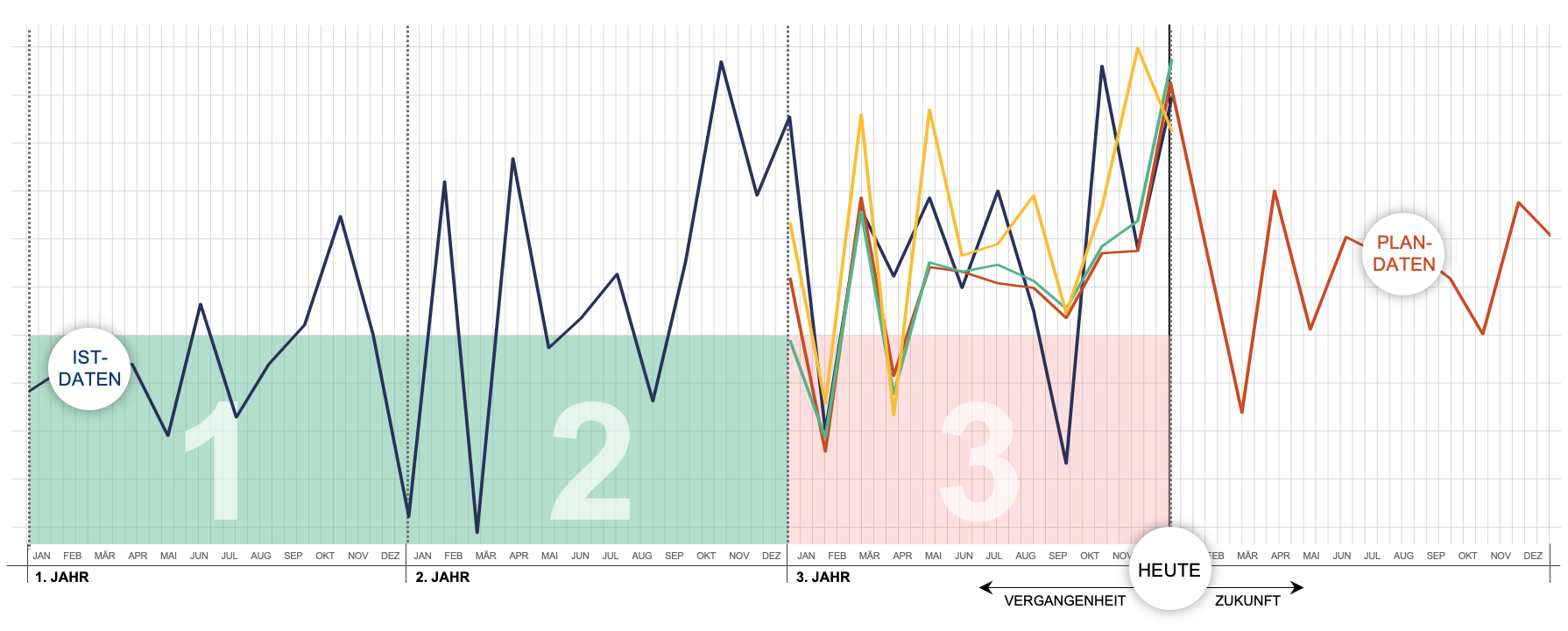

Die wichtigste Zutat für präzise Vorhersagen sind Ihre historischen Daten. Diese Daten werden mit einem statistischen Rechenmodell auf Verläufe und Muster analysiert und so in die Zukunft fortgeschrieben. Damit das funktioniert, muss das System das Modell im Vorfeld kalibrieren, damit es wiederkehrende Ereignisse (z.B. Feiertagseffekte) einordnen und Datenausreißer ignorieren kann (Abb. 1).

Was so verkürzt recht einfach klingt, ist ein komplexer Prozess, in dem das System viele Variablen und Parameter beachten und in periodischen Abständen überprüfen und erweitern muss. Außerdem stehen für die Berechnungen fast zwanzig unterschiedliche statistische Modelle zur Verfügung, deren Eignung je nach Planungskategorie und Datenqualität stark variiert. Die Auswahl des richtigen Modells ist damit genauso wichtig wie seine Modellierung und muss genauso regelmäßig überprüft werden, damit die Berechnungen mit der Zeit immer präziser werden.

Abb. 1: Muster in der Vergangenheit geben Ausblick auf die Zukunft

Stark vereinfachte Darstellung von Predictive Analytics.

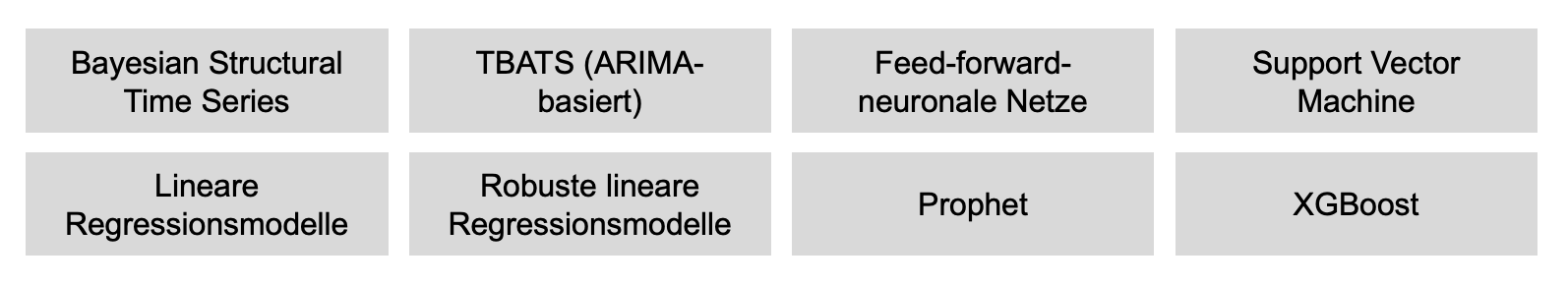

Von der Theorie in die Praxis: Am Anfang müssen die Rahmenbedingungen geklärt und die Datenbasis bereitgestellt werden

Ganz am Anfang analysieren wir gemeinsam mit Ihnen, welche Daten für Ihre Vorhersage relevant sind. Diese müssen für einen Zeitraum von mindestens drei Jahren zur Verfügung stehen, um für Predictive Analytics eingesetzt werden zu können. Sobald die Datenlage geklärt ist, übernimmt Nomentia die Daten automatisch aus den vorhandenen Vorsystemen in die Liquiditätsplanung.

Außerdem muss natürlich für jede Planungskategorie definiert werden, in welchen Währungen geplant, welcher Planungshorizont (auf Tages-, Wochen- oder Monatsbasis) betrachtet und für welchen Vorhersagezeitraum geplant werden soll.

Allgemeine und individuelle Einflussfaktoren bestimmen und modellieren

Zu Beginn der Analyse steht das genaue Verständnis des Geschäftsmodells Ihres Konzerns. Mit welchen äußeren und inneren Einflussfaktoren auf die Cashflows müssen Sie im Treasury in der Zukunft rechnen? Die Bewertungen dieser Faktoren führen in Summe zu soliden und belastbaren Plandaten. Deswegen besprechen unsere Data Scientists ganz am Anfang schon alle bekannten Einflussfaktoren (Abb. 2) mit Ihnen und wie deren Modellierung möglich ist bzw. was dabei zu berücksichtigen ist. Dieser Schritt am Anfang ist entscheidend, weil statistische Methoden nur dann aussagekräftige Ergebnisse liefern können, wenn sie im Vorfeld nicht nur einmalige Datenausreißer, sondern auch laufende Abhängigkeiten von anderen Faktoren „gelernt“ haben.

Es gibt allgemeine Einflussfaktoren, die jede Branche und jedes Unternehmen betreffen, auch wenn sie individuell sehr verschieden sind: Feiertage variieren nicht nur international, sondern auch national von Bundesland zu Bundesland, und ihre Auswirkung auf den Einzelhandel ist eine ganz andere als auf die Tourismusbranche. Gleiches gilt für saisonale Schwankungen und Trends. Eines aber haben diese Faktoren gemeinsam: sie sind nahezu für jedes Unternehmen relevant, haben massive Auswirkungen auf die Cashflow-Entwicklung und müssen deswegen noch vor dem ersten Testlauf modelliert werden. Während Feiertagseffekte sich mit einem einfachen Kalenderupload modellieren lassen, ergeben sich saisonale Effekte und Trends vor allem aus der Analyse der historischen Daten. Diesen Schritt übernimmt Nomentia automatisch und analysiert, ob saisonale Effekte,Trendwechsel oder Aufholeffekte nach Feiertagen in den einzelnen Planungskategorien bestehen.

Individuelle Einflussfaktoren betreffen spezifisch Ihre Branche oder sogar nur Ihr Unternehmen. Entsprechend unterscheidet sich auch die Datenlage und -aufbereitung für die Modellierung. Externe Faktoren modelliert Nomentia mit allgemeinen Wirtschaftsdaten wie Wechselkursen oder Konjunkturdaten, die in der Regel von Datenprovidern bezogen werden können. Interne Faktoren, wie beispielsweise fixe Zahlungstermine, laden wir hoch und integrieren sie so in die Rechenmodelle. Viele individuelle Faktoren sind am Anfang noch nicht bekannt oder die Datenlage reicht nicht aus, um sie direkt modellieren zu können. Je länger Ihre Planung im Einsatz ist, umso größer wird der Datenschatz, um hier nachzujustieren. Damit werden Ihre Planwerte mit der Zeit immer präziser.

Abb. 2: Allgemeine und individuelle Einflussfaktoren

Einflussfaktoren ergeben Muster, die von den Modellen erkannt werden, sich aber nicht 1:1 auf die Zukunft übertragen lassen. Diese Faktoren müssen modelliert werden, um die Qualität der Plandaten zu verbessern.

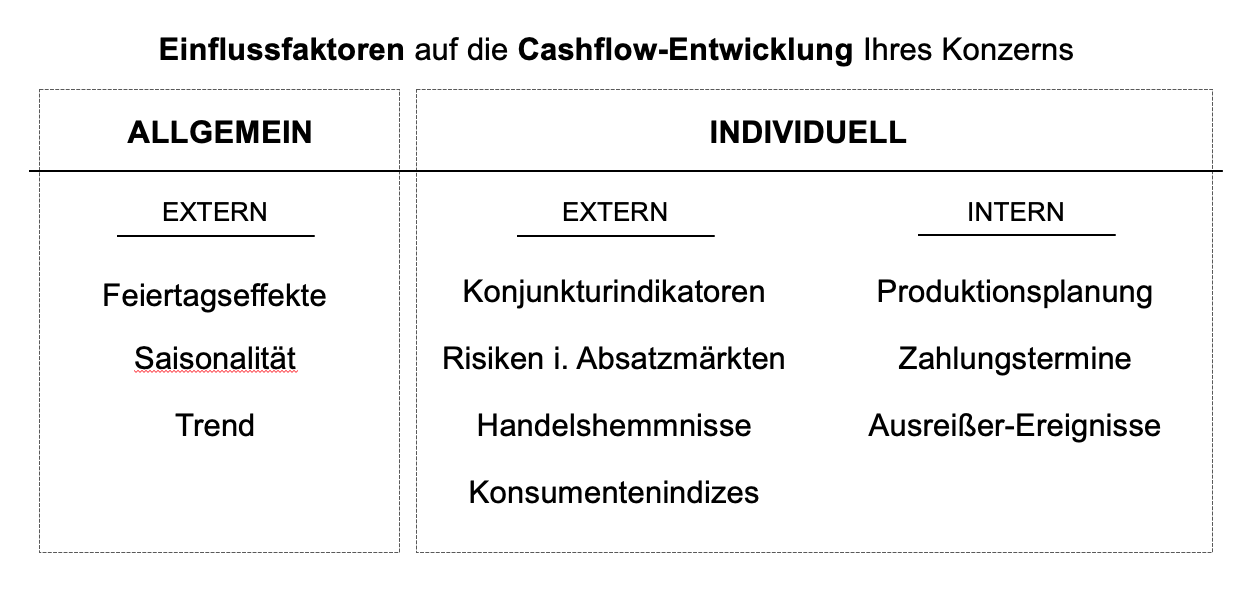

Welches statistische Modell passt zu welcher Planungskategorie?

Die zentrale Herausforderung im Umgang mit Predictive Analytics liegt darin, aus den statistischen Modellen für jede einzelne Planungskategorie das individuell passende zu ermitteln.

Abb. 3: Statistische Modellgruppen, die Nomentia für Predictive Analytics einsetzt

Es gibt unendlich viele statistische Modelle, die sich aber nicht alle für die Liquiditätsplanung eignen. Nomentia arbeitet mit den acht abgebildeten Modellgruppen.

Aktuell setzen wir acht Modellgruppen ein, die unterschiedliche Stärken und Schwächen haben. Regressionsmodelle können zum Beispiel gut mit fehlenden Daten von Teilperioden umgehen, was für ARIMA-basierte Modelle eine Herausforderung darstellt. Neuronale Netze sind sehr gut darin, Muster zu erkennen, wofür sie aber eine große Datenmenge als Ausgangsbasis brauchen, die bei einer Planung auf Monatsebene nicht vorhanden ist. Eine automatisierte Analyse der vorhandenen Datenlage zeigt bereits, welche Modelle von vornherein nicht infrage kommen und damit gar nicht erst zum Testlauf antreten müssen. Das ist durchaus wesentlich, da mit vielen Planungskategorien und Modellen sowie deren Modellierung ein erheblicher Rechenaufwand entsteht, der sowohl Rechenkapazität als auch Zeit kostet. Diesen im Vorfeld auf sinnvolle Berechnungen zu reduzieren, ist wesentlich für die Performance des Verfahrens.

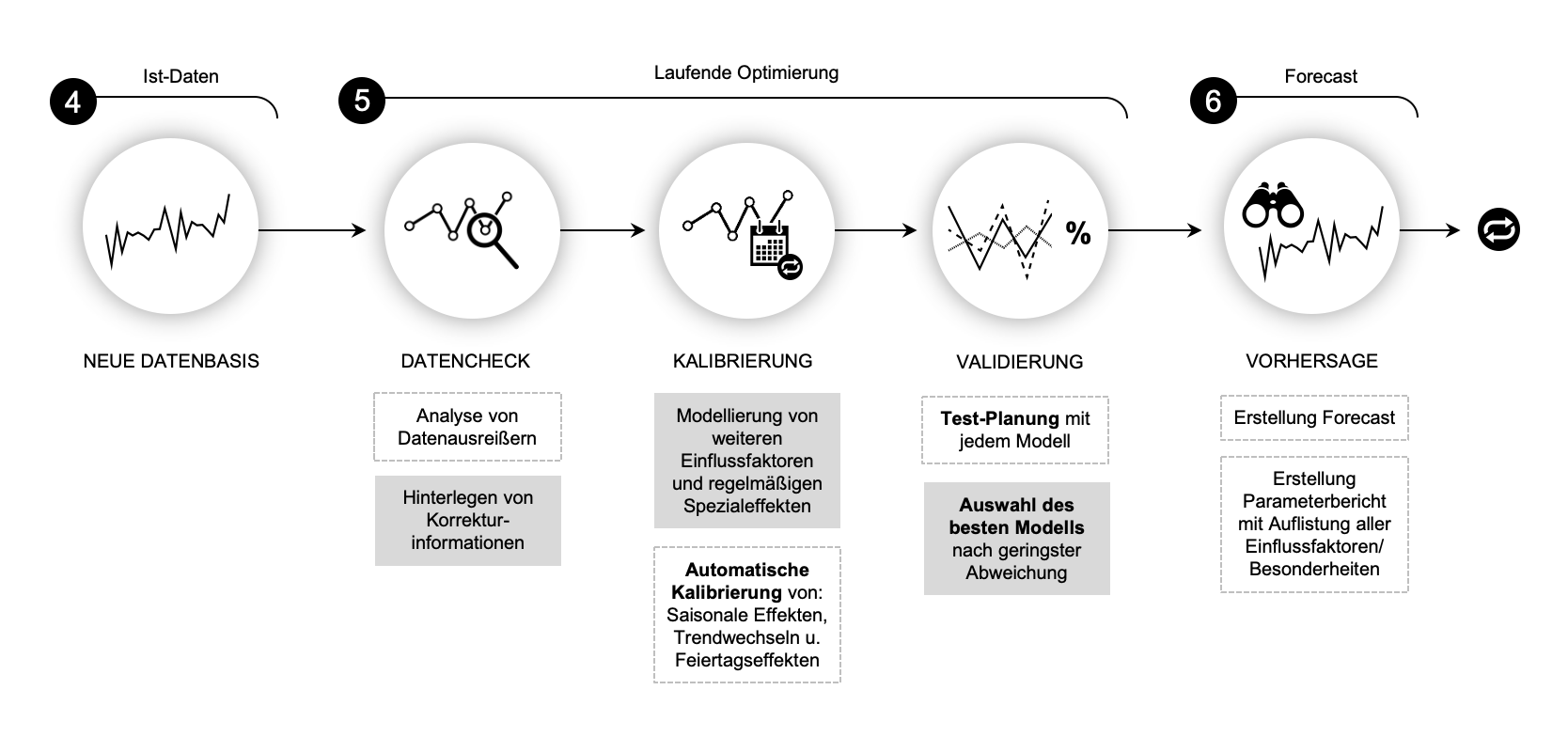

In der Regel ergibt die Datenanalyse eine Vorauswahl von fünf bis sechs Modellen für den Testlauf. Nomentia kalibriert die Modelle mit den bereits identifizierten Einflussfaktoren und errechnet auf Basis von historischen Ist-Daten (mind. drei Jahre müssen vorliegen) eine Test-Planung für die zuletzt vorliegenden zwölf Monate. Die Abweichungen zu den Ist-Daten dieses dritten Jahres werden anschließend für jedes Modell analysiert und das beste Modell ausgewählt.

Abb. 4: Testlauf mit historischen Ist-Daten und Analyse des besten Rechenmodells

Die ersten zwei Ist-Jahre werden zur Validierung des passenden Rechenmodells verwendet. Das Modell, das den Ist-Daten aus dem dritten Jahr am nächsten kommt (roter Graph), wird schließlich für die Plandaten-Berechnung ausgewählt.

Die Implementierung im Überblick

Sobald die Eckdaten der Planung und die benötigte Datenbasis definiert sind, erfolgt der gesamte Prozess von der Datenanalyse über die Modellvorauswahl, die Kalibrierung und Validierung der Modelle bis hin zur „finalen“ Modellauswahl und der Berechnung des ersten Forecasts weitgehend automatisch. Lediglich die Datenausreißer sollten Sie im Sinne besserer Forecasts individuell betrachten und mit Korrekturinformationen hinterlegen. Die Auswahl des passenden Modells können Sie automatisch nach kleinster Abweichung erfolgen lassen oder aus taktischen Überlegungen manuell angepassen. Das ist vor allem dann sinnvoll, wenn die historischen Daten über große Strecken von außergewöhnlichen Einflussfaktoren (Wirtschaftskrise, Naturkatastrophen, Pandemien) dominiert werden und nicht der „Normalität“ entsprechen. In diesen Fällen kann es vorkommen, dass ein Modell zufällig gut performt, während ein anderes trotzdem auf lange Sicht besser passt.

Abb. 5: Der Prozess im Überblick von der Vorbereitung bis zum ersten Forecast

Am Anfang sind noch Aufgaben notwendig, die das System in Zukunft eigenständig übernimmt.

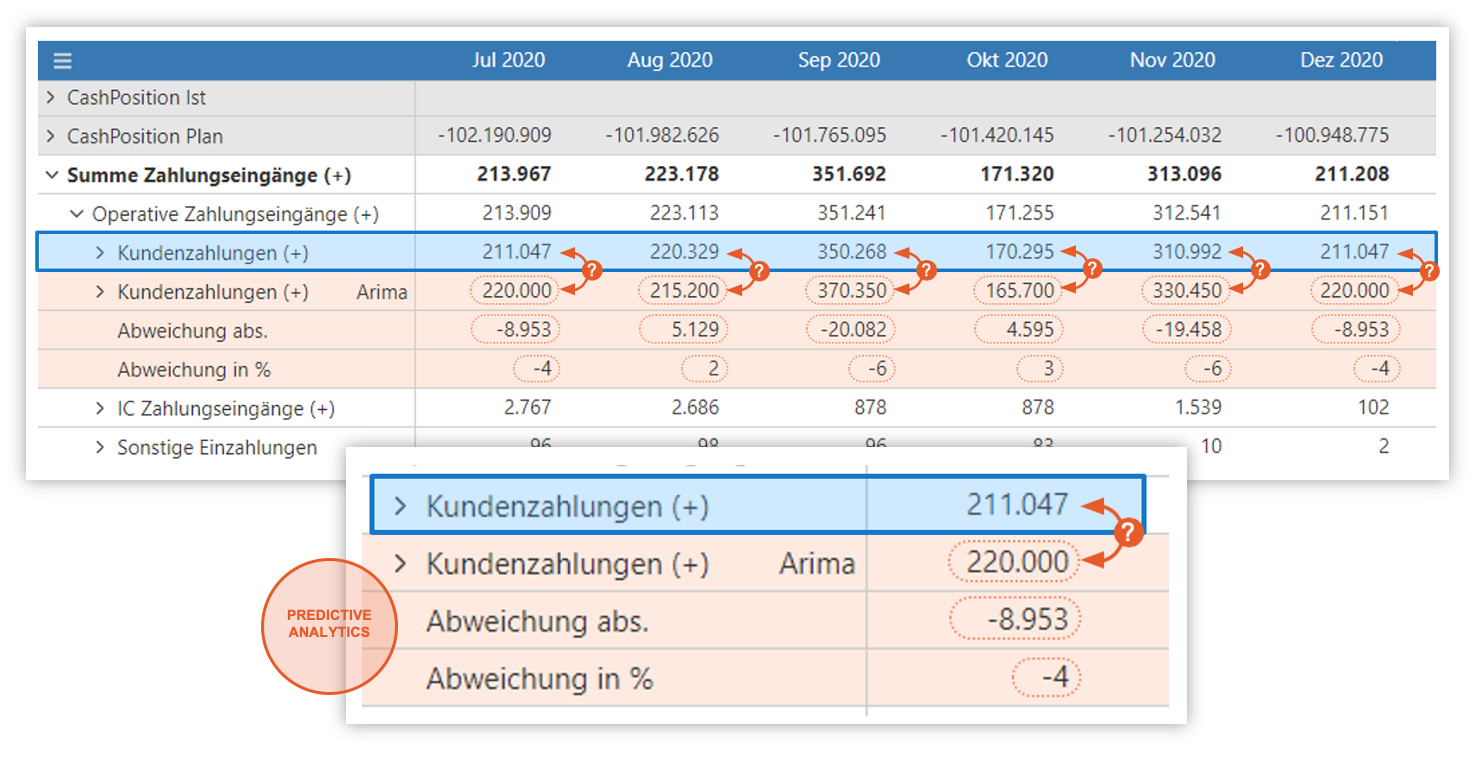

Der erste automatisch generierte Forecast

Die generierten Plandaten sind eine gute Grundlage für das Treasury, um in Kombination mit individuellem Fachwissen in kurzer Zeit eine professionelle Liquiditätsplanung zu erstellen. Für manche Planungskategorien (z.B. Gehälter) funktioniert das so zuverlässig, dass Nomentia auf Wunsch direkt eine Liquiditätsplanung erstellt. Für Kategorien, die häufig von Ausnahmen dominiert werden, ist es sinnvoller, die berechneten Zahlen als Vorschlagswerte in der klassischen Planungsoberfläche anzuzeigen. In diesem Fall sind die vorliegenden Daten eine große Orientierungshilfe für das manuelle Finetuning und sparen wertvolle Zeit (Abb. 6).

Abb. 6: Vorschlagswerte in der manuellen Planung

Vor allem am Anfang sind manuelle Anpassungen wichtig, in manchen Kategorien bleiben sie aber an der Tagesordnung. Dann gibt Predictive Analytics vor allem die Grundlinie vor, die manuell leicht justiert werden kann.

Aber nicht nur die Plandaten selbst, sondern auch die Schätzergebnisse und Beobachtungen, die in ihnen stecken, sind von großem Wert. Nomentia stellt alle relevanten Informationen in einem Bericht zusammen und generiert ihn gemeinsam mit den Plandaten:

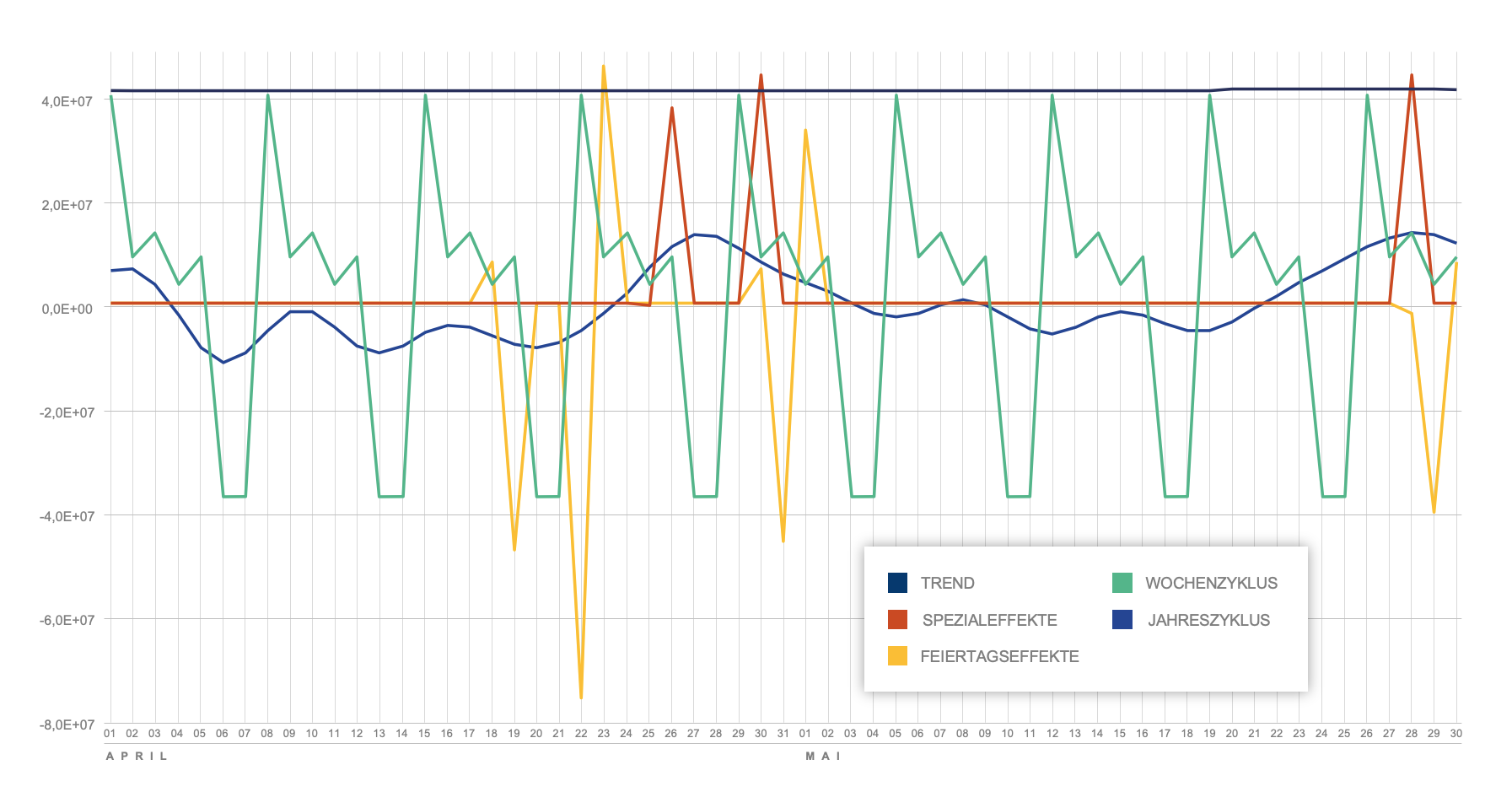

- Vorhersage zerlegt in Komponenten je Einflussfaktor (Abb. 7)

- Größe und statistische Signifikanz der einzelnen Effekte

- Detailgrad der Saisonalitäts-Modellierung

- Erkannte Trendbrüche

- Verteilung der Residuen (Schätzfehler)

- Statistische Testergebnisse (z.B. Heteroskedastizität, Autokorrelation, …)

- Automatische Voridentifikation potentieller Ausreißer

Abb. 7: Allgemeine Einflussfaktoren in Komponenten aufgeschlüsselt

Für die Überprüfung der einzelnen Effekte kann eine visuelle Darstellung je nach Faktor sinnvoll sein

Mithilfe dieser Informationen kann jeder Treasurer schnell nachvollziehen, wie die prognostizierten Zahlen entstanden sind. Das ist hilfreich, sowohl um schnell Prognosefehler zu identifizieren, als auch um zu verstehen, welche Faktoren für eine plötzliche Veränderung verantwortlich sind. Das dient zum einen der Transparenz und vereinfacht zum anderen die Kontrolle.

Laufende Optimierung führt zu immer akkurateren Plandaten

Der erste Durchlauf verlangt noch nach einiger Aufmerksamkeit und manuellen Tätigkeiten, aber sobald diese Hausaufgaben erledigt sind, löst das System mehr und mehr Schritte selbständig. Außerdem werden die Berechnungen immer präziser, umso mehr Ist-Daten in der idealen Granularität zur Verfügung stehen. Deswegen prüft Nomentia vor jedem neuen Forecast nach, ob die Modell-Auswahl noch passt oder ein anderes Modell mittlerweile bessere Ergebnisse erzielt. Das Auswahlprozedere bleibt dabei im Grunde das gleiche, nur werden bereits modellierte Einflussfaktoren völlig automatisch für die Kalibrierung herangezogen, was auch die Testberechnungen immer präziser macht. Selbstverständlich kann die Treasury Abteilung auch zu jedem Zeitpunkt die Modelle mit weiteren oder besseren Einflussfaktoren kalibrieren, um die Vorhersagen zu verbessern.

Abb. 8: Fortlaufende Feinjustierung vor jedem neuen Forecast

Je länger das System im Einsatz ist, umso präziser werden die Vorhersagen. Neu zur Verfügung stehende Ist-Daten im Abgleich mit der letzten Vorhersage bieten eine immer besser werdende Basis für die Berechnungen.

Für wen eignet sich Predictive Analytics?

Je volatiler sich die Cashflows eines Unternehmens entwickeln, umso unwahrscheinlicher ist es, dass die Modelle in den historischen Daten brauchbare Muster erkennen können. Deswegen eignet sich das Verfahren vor allem für den B2C-Bereich und für Tochterfirmen mit einer breiten Kundenbasis, da die Cashflow-Entwicklung in diesen Fällen nicht von großen Einzelzahlungen dominiert wird. Trotzdem hat das Verfahren auch für kleinere Tochterfirmen mit Großprojekten im B2B-Bereich seinen Wert. Auch wenn die Daten in diesen Fällen aufmerksam geprüft und manuell nachjustiert werden müssen, birgt das Verfahren den Vorteil, dass bekannte Einflussfaktoren digital dokumentiert sind und damit vereinheitlicht vorliegen – Stichwort „Digitalisierung der Planung“. Wenn Mitarbeiter das Unternehmen verlassen, bleibt ihr Wissen erhalten und die Qualität der Vorhersagen ist gesichert.